La falla en programas que leen los escáneres cerebrales que puede invalidar 15 años de investigación

La falla en programas que leen los escáneres cerebrales que puede invalidar 15 años de investigación

La falla en programas que leen los escáneres cerebrales que puede invalidar 15 años de investigación

T13 En Vivo

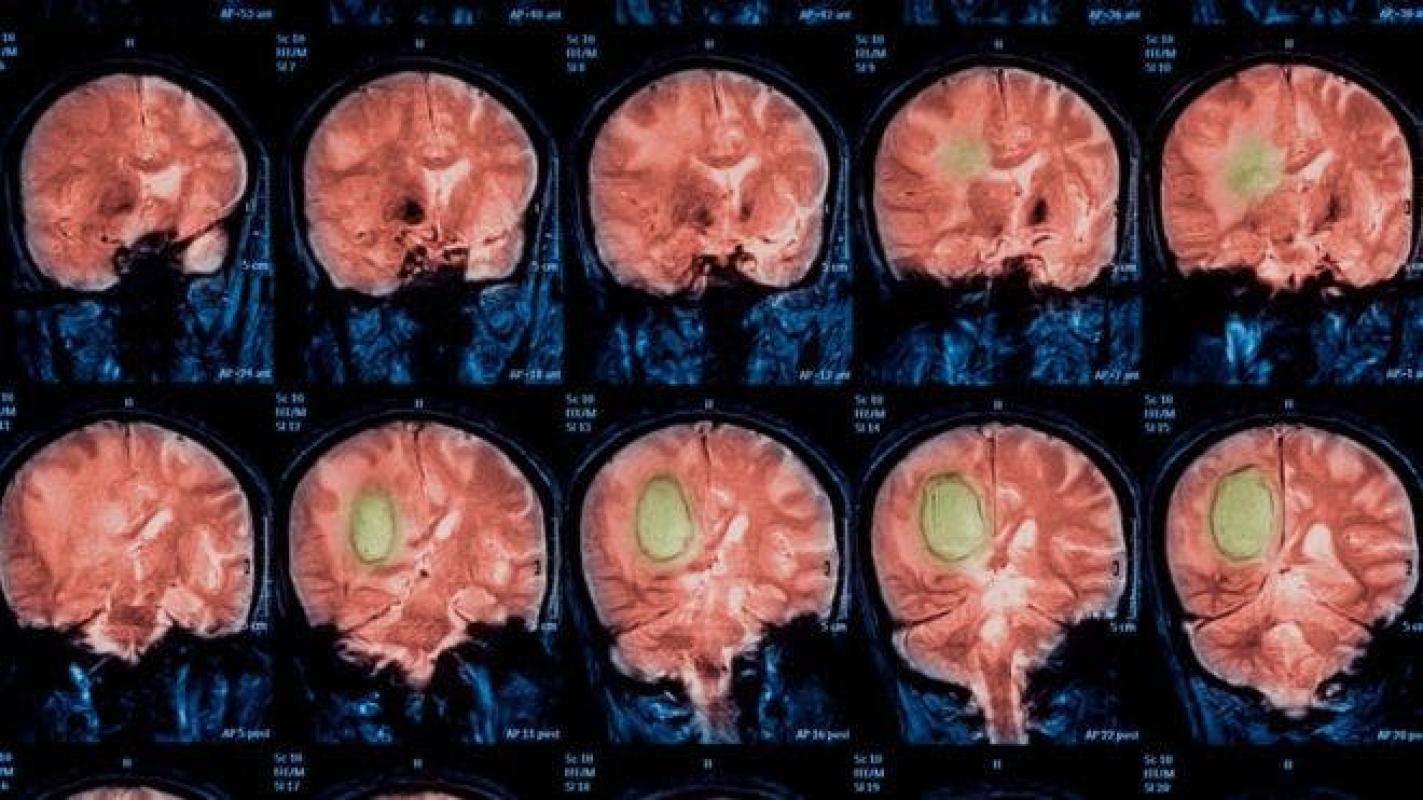

Desde que hace más de 20 años se empezaron a usar imágenes por resonancia magnética funcional (IRMf) para entender el comportamiento de nuestro cerebro, se han publicado unos 40.000 trabajos en el área de la neurociencia.

Ahora, un estudio sobre los programas que se utilizan para interpretar esas imágenes de los escáneres cerebrales pone en duda la veracidad de los resultados de esas investigaciones.

El equipo del investigador Anders Eklund, de la universidad de Linköping, en Suecia, decidió poner a prueba los tres programas informáticos más usados -SPM, FSL y AFNI- y encontró errores en su software.

"Quedé sorprendido con el resultado", le dijo a BBC Mundo. "Yo meesperaba encontrar márgenes de error de 5%, pero no del 20, 40 y hasta 70%".

"No esperé que fuera a ser tan malo", agregó.

Hoy en día, muchos científicos utilizan IRMf para saber cómo reacciona nuestro cerebro a por ejemplo la música, videojuegos, violencia, amor, tristeza, etc.

Normalmente le piden a pacientes sanos que realicen una actividad y los expertos observan las áreas del cerebro que se iluminan.

Esos vóxel brillantes -el equivalente a los píxeles en imágenes 2D- aparecen gracias al programa informático que tiene la máquina. En realidad no están mirando el cerebro, sino una interpretación hecha por computadora.

3.000.000 de comparaciones

Para probar qué tan precisos eran los programas, el equipo de Eklund, quien es experto en el procesamiento de imágenes médicas, analizó los datos de 499 personas sanas de todas partes del mundo, los dividió en grupos y realizó 3 millones de comparaciones aleatorias.

Descubrió que los software llegaron a arrojar tasas de falsos positivos de hasta el 70%, donde se mostraba actividad en partes del cerebro donde en realidad no había.

"Esto es serio", sentencia Eklund. "Esto significa que algunos estudios están errados".

En el trabajo publicado en el Proceedings of the National Academy of Sciences, los investigadores escriben que sus hallazgos"cuestionan la validez de unos 40.000 estudios con IRMf y pueden tener un gran impacto en la interpretación de los resultados de imágenes neuronales".

Uno de los problemas que descubrieron fue una falla informática en los programas que parece haber estado durante 15 años.

La buena noticia es que para el momento en que se escribió el trabajo, en 2015, esta falla se había arreglado.

La no tan buena noticia es que "encontramos muchos métodos estadísticos que estaban basados en suposiciones que no eran correctas".

Bola de nieve

Tal y como funciona la literatura científica hace que sea muy difícil validar la metodología que se utiliza en los trabajos.

Es a partir de los resultados publicados que otros científicos basan sus nuevos estudios, por lo que una investigación con errores puede ser citada decenas de veces por otros expertos, cuyos trabajos serán usados a su vez por muchos otros, antes de que se descubra un error.

Esta puede ser la primera vez que alguien decide poner a prueba de una forma rigurosa y con datos reales los resultados arrojados por los programas informáticos.

"Nos llevó un año hacer todos los cálculos", cuenta el experto. "El mayor problema fue que los datos de las investigaciones no están disponibles".

El experto señala que el hecho de que sea tan costoso hacer investigaciones con IRMf tampoco ayuda en la validación de los estudios.

Un escáner puede costar unos US$600 la hora, lo que dificulta la posibilidad de hacer estudios a gran escala, con muchos pacientes.

Para Eklund, la lección que saca es que "en el futuro debemos ser más cuidadosos con nuestros trabajos".

También subrayó la importancia de compartir todos los datos de los trabajos, pues es una manera de verificar si hay errores y evitar arrastrarlos en otras investigaciones.