"Wafer Scale Engine": cómo es el chip de computadoras más grande del mundo y qué utilidades tendrá

"Wafer Scale Engine": cómo es el chip de computadoras más grande del mundo y qué utilidades tendrá

"Wafer Scale Engine": cómo es el chip de computadoras más grande del mundo y qué utilidades tendrá

T13 En Vivo

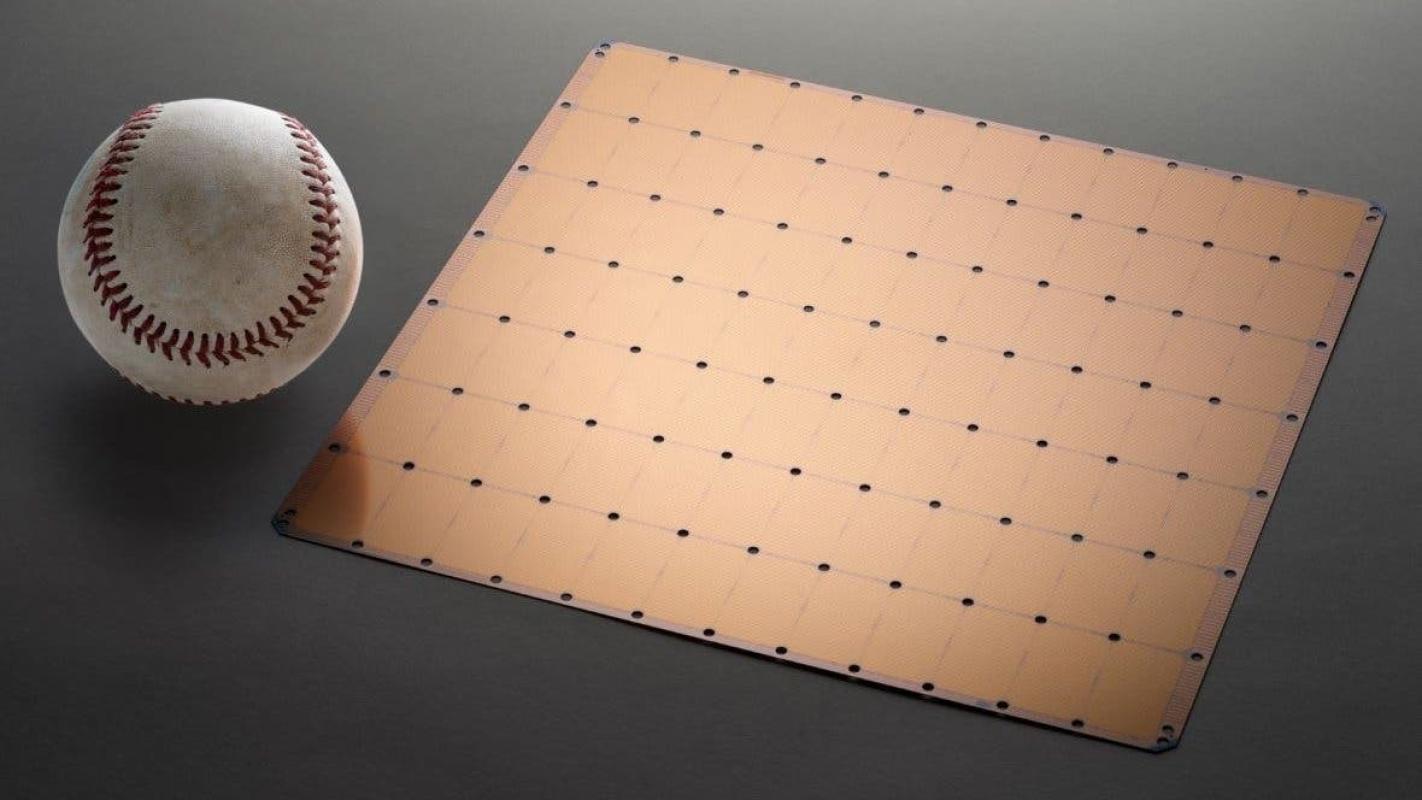

Su tamaño es 56 veces más grande que el de los que existen en el mercado.

Una empresa con sede en California, Estados Unidos, dio a conocer lo que asegura es el chip de computadoras más grande del mundo.

El nuevo producto lleva por nombre Wafer Scale Engine (WSE) y, para hacernos una idea, es más grande que un iPad estándar.

Cerebras Systems, la compañía responsable de esta innovación, asegura que estas características sin precedentes serán útiles al ofrecer mayor capacidad de cómputo, más memoria y más ancho de banda para comunicaciones.

Esto haría posible que los desarrolladores de Inteligencia Artificial (IA) trabajen "a mayores velocidades y escalas que no eran posibles antes", afirman.

De hecho, la compañia dice que un solo chip será capaz de soportar sistemas complejos de IA en todas las áreas, desde los vehículos autónomos hasta los software de vigilancia.

Pero, a pesar de las bondades señaladas por sus creadores, algunos expertos tienen dudas sobre cuán práctica será la instalación de los nuevos dispositivos en muchos centros de procesamiento de datos.

¿Cuál es la importancia de una innovación como esta y cuáles podrían ser sus desventajas?

Más rapidez y menos requisitos de energía

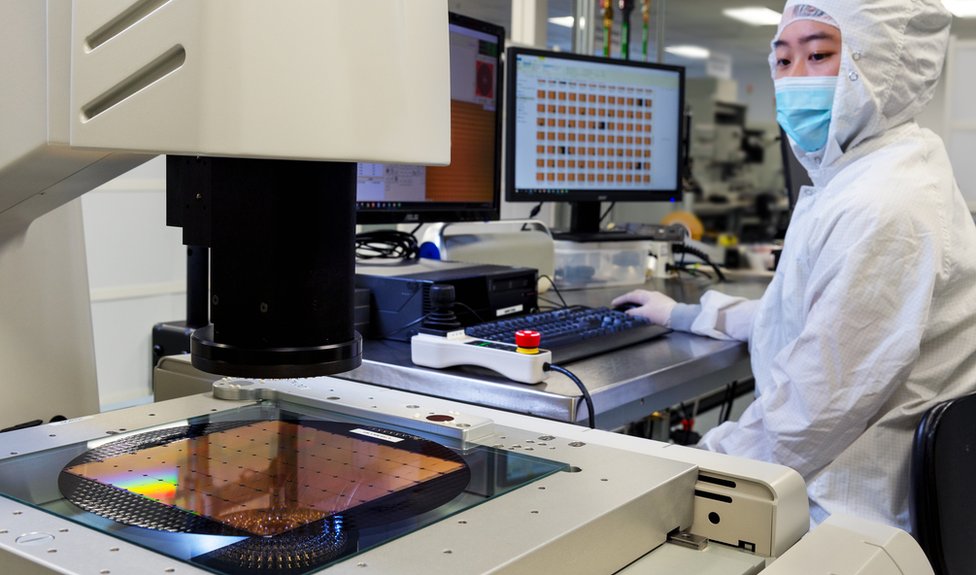

Los chips informáticos se han vuelto más pequeños y más rápidos a lo largo de los años. Por lo general, son fabricados por docenas en una sola "oblea" de silicio, que luego se corta para separar unos de otros.

Las Unidades Centrales de Procesamiento (CPU, por sus siglas en inlgés) de escritorio más potentes poseen alrededor de 30 núcleos de procesador. Cada uno capaz de manejar su propio conjunto de cálculos, simultáneamente.

Por su parte, las Unidades de Procesamiento de Gráficos (GPU) tienden a tener más núcleos, aunque menos potentes. Esto tradicionalmente los ha convertido en la opción preferida para los procesos de IA.

Las GPU más potentes tienen hasta 5.000 núcleos. Pero el nuevo chip de Cerebras tiene 400.000 núcleos, unidos entre sí por conexiones de gran ancho de banda.

La firma asegura que esto le da una ventaja al manejar desafíos complejos de aprendizaje automático con menos retraso y menores requisitos de energía que sus antecesores.

Cerebras afirma que el WSE reducirá de meses a minutos el tiempo que lleva procesar algunos datos complejos.

Su fundador y director ejecutivo, Andrew Feldman, dijo que con su innovación la empresa había "superado desafíos técnicos de décadas".

"Reducir el tiempo de capacitación elimina un importante cuello de botella para el progreso de toda una industria", dijo.

¿Cuales son las desventajas?

Cerebras dijo que ya comenzó a enviar este hardware a un pequeño número de clientes, aunque se desconoce el precio de cada unidad.

Sin embargo, algunos expertos en tecnología han comenzado a sopesar las posibles desventajas de esta innovación.

Ian Cutress, editor sénior del sitio de noticias AnandTech, dice que la mayor rapidez que traerá el nuevo chip tendrá su costo.

"Una de las ventajas de los chips de computadora más pequeños es que usan mucha menos energía y son más fáciles de mantener frescos", explica.

Cutress sostiene que cuando se emplean chips más grandes como este, las compañías que los comienzan a usar necesitan una infraestructura especializada para soportarlos.

En su opinión, esto limitará el número de clientes para el nuevo producto, pues no todos podrán usarlo.

"Es por eso que es adecuado para el desarrollo de inteligencia artificial, ya que es donde se están moviendo grandes cantidades de dinero en este momento".

Otros chips exitosos

Cerebras está lejos de ser la primera compañía en desarrollar chips para alimentar sistemas de IA.

En 2016, Google desarrolló chips de Unidad de Procesamiento de Tensor (TPU) para alimentar su software, incluida su aplicación de traducción de idiomas, y ahora vende la tecnología a terceros.

Al año siguiente, la compañia china Huawei anunció que sus chips Kirin de teléfonos inteligentes habían obtenido una NPU (Unidad de Procesamiento Neuronal) para ayudar a acelerar el cálculo de las multiplicaciones de matrices, un tipo de matemática comúnmente involucrada en tareas de IA.

Pero no todos estos esfuerzos han tenido éxito.

A principios de la década de 1980, la compañía estadounidense Trilogy recibió cientos de millones de dólares en fondos para crear su propio superchip.

Sin embargo, los procesadores se calentaron demasiado durante las pruebas y fueron menos potentes de lo que inicialmente se pensaba.

Plagada de desafíos técnicos y personales, la compañía renunció al proyecto cinco años después.